Az Nvidia, az AMD és az Intel a mesterséges intelligencia és a gépi tanulás igényei által táplált, növekvő grafikus feldolgozóegység-piac mind nagyobb és nagyobb szeleteiért küzdenek.

A modern grafikus feldolgozóegység (GPU) a Windows videojátékok gyorsítójaként indult, de az elmúlt 20 év során a nagyteljesítményű számítási és mesterséges intelligencia alkalmazások vállalati szerverprocesszorává alakult át.

Ma a GPU-s szuperszámítógépek állnak a mesterséges intelligencia betanítás és következtetés, a gyógyszerkutatás, a pénzügyi modellezés és az orvosi képalkotás területén használt teljesítményhegyek csúcsán. A GPU-kat általánosabb feladatokban is alkalmazzák olyan helyzetekben, amikor a CPU-k egyszerűen nem elég gyorsak, mint például a GPU-alapú relációs adatbázisok gyorsítása.

Ahogy nő a GPU-k iránti kereslet, úgy nő a verseny a szerver GPU fejlesztők és gyártók között és csak három dominál: Az Nvidia, az AMD és az Intel. Az Intel már kétszer is próbálkozott és kétszer is elbukott azzal, hogy alternatívát kínáljon a többiek GPU-ival szemben, de most újra nekifut.

A GPU-k jelentősége az adatközpontokban

A három gyártó felismerte, hogy a GPU-k iránti igény az adatközpontokban növekvő lehetőséget jelent. Ennek oka, hogy a GPU-k a CPU-knál alkalmasabbak a vállalati adatközpontokban és a hiperskaler hálózatokban az AI és a gépi tanulás által megkövetelt számos számítás elvégzésére. A CPU-k is képesek elvégezni a munkát, csak épp tovább tart nekik.

Mivel a GPU-kat úgy tervezték, hogy az összetett matematikai problémákat párhuzamosan, különálló feladatokra bontva oldják meg, amelyeken egyszerre dolgoznak, gyorsabban oldják meg azokat. Ennek érdekében több maggal rendelkeznek, sokkal-sokkal többel, mint az általános célú CPU-k. Az Intel Xeon Scalable Gen2 szerver CPU-k például maximum 28 maggal rendelkeznek, míg az AMD Epyc szerver CPU-k akár 64 maggal. Ezzel szemben az Nvidia jelenlegi GPU-generációja, az Ampere 6912 maggal rendelkezik, amelyek mind párhuzamosan működnek, és egyetlen dolgot végeznek: matematikai feldolgozást, különösen lebegőpontos matematikát.

A GPU-k teljesítményét abban mérik, hogy hány ilyen lebegőpontos matematikai műveletet képesek másodpercenként elvégezni és FLOPS-nak nevezik. Ez a szám néha megadja a méréskor használt szabványosított lebegőpontos formátumot is, például FP64.

Mit hoz az év a szerver GPU-k számára? Elég sok mindent, mint kiderült. Az Nvidia, az AMD és az Intel kiterítette a kártyáit a közeljövő terveiről, és úgy tűnik, hogy kemény verseny lesz. Íme egy pillantás arra, hogy mit tartogat az Nvidia, az AMD és az Intel.

Nvidia

Az Nvidia márciusban a Hopper GPU-architektúra bejelentésével határozta meg az idei GPU-útitervét, és azt állította, hogy a felhasználástól függően háromszor-hatszor nagyobb teljesítményre képes, mint az előző, 9,7 TFLOPS FP64-es teljesítményű Ampere architektúra. Az Nvidia szerint a Hopper H100 csúcsértéke 60 TFLOPS FP64 teljesítmény lesz.

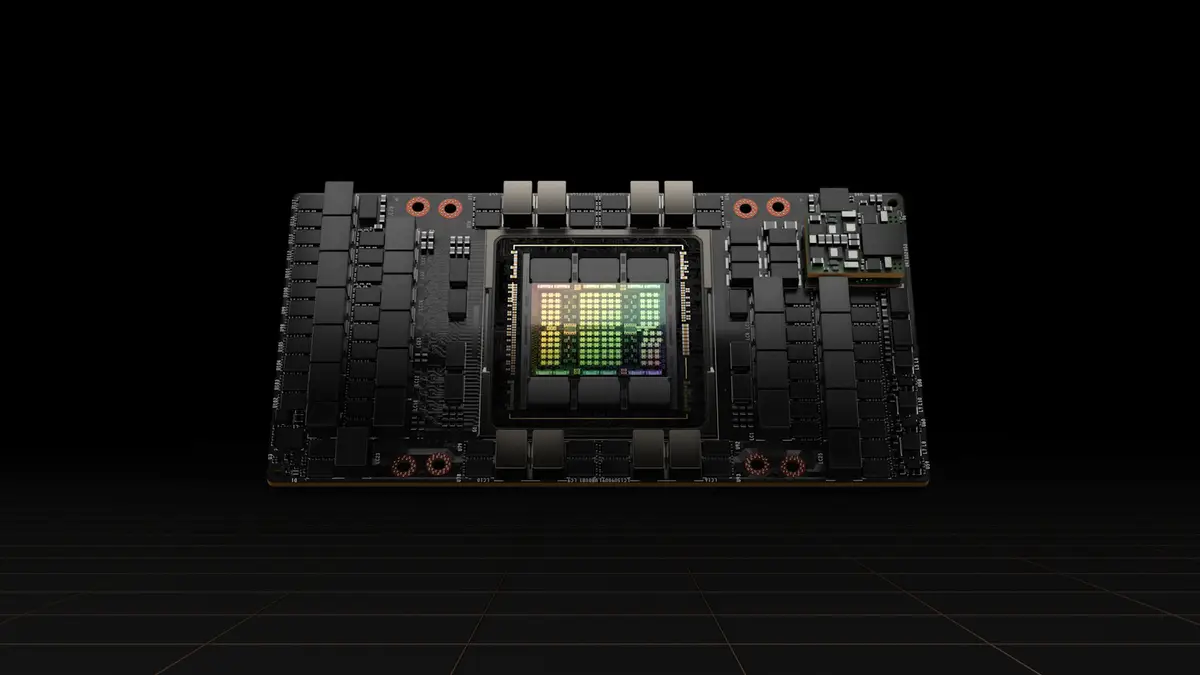

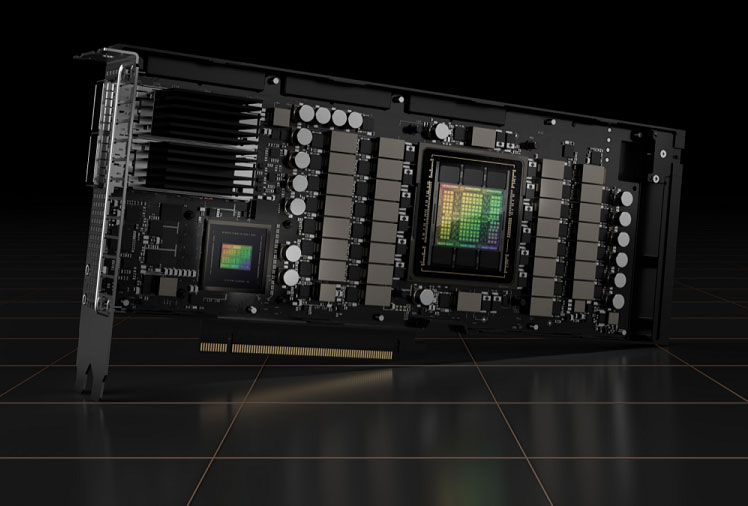

Nvidia H100 CNX konvergens GPU gyorsító.

Nvidia H100 CNX konvergens GPU gyorsító.A korábbi GPU-khoz hasonlóan a Hopper H100 GPU is képes önálló processzorként működni, amely egy szerver PCI Express kiegészítő kártyáján fut. Az Nvidia azonban párosítani fogja egy CPU-val is, amely az általa kifejlesztett és várhatóan 2023-ban elérhetővé váló Grace nevű egyedi Arm processzoron fut.

A Hopper esetében az Nvidia nem csak a GPU-processzort erősítette fel. Módosította az alacsony fogyasztású, dupla adatátviteli sebességű (LPDDR) 5 memóriát is – amelyet általában az okostelefonokban használnak -, hogy létrehozza az LPDDR5X-et. Ez támogatja a hibajavító kódot (ECC) és a hagyományos DDR5 memória sávszélességének kétszeresét, ami 1 TBps átviteli sebességet jelent.

A Hopperrel együtt az Nvidia bejelentette az NVLink 4-et, a legújabb GPU-GPU közötti összeköttetést. Az NVLink 4C2C lehetővé teszi, hogy a Hopper GPU-k közvetlenül beszéljenek egymással, a maximális teljes sávszélesség 900 GB – hétszer gyorsabb, mintha PCIe Gen5 buszon keresztül csatlakoznának.

„Ha az adatközponti termékekre gondolunk, három komponensből áll, és mindnek ugyanabban a tempóban kell haladnia. Ez a memória, a processzor és a kommunikáció” – mondta Jon Peddie, a Jon Peddie Research elnöke. „Az Nvidia ezt tette a Hopperrel. Ez a három technológia nem szinkronban mozog, de az Nvidia ezt elérte.”

Az Nvidia a Hopper GPU-t 2022 harmadik negyedévétől tervezi szállítani. Az OEM-partnerek között szerepel az Atos, a BOXX Technologies, a Cisco, a Dell Technologies, a Fujitsu, a GIGABYTE, a H3C, a Hewlett Packard Enterprise, az Inspur, a Lenovo, a Nettrix és a Supermicro.

A chipgyártó TSMC-nél tapasztalható folyamatos ellátási nyomás miatt az Nvidia megnyitotta az ajtót az Intel öntödei üzletágával való esetleges együttműködés előtt, de figyelmeztetett, hogy egy ilyen üzlet még évekig várat magára.

AMD

Az AMD épp hátszeles szakaszban van. Az eladások negyedévről negyedévre nőnek, x86 CPU piaci részesedése növekszik, és februárban befejezte a Xilinx és az ő FPGA, adaptív rendszerek egy chipen (SoC), AI-motorjai és szoftveres szakértelme felvásárlását. Az AMD várhatóan 2022 végére dobja piacra Zen 4 CPU-ját.

Az AMD új, RDNA 3 architektúrán alapuló játék GPU-jai szintén idén jelennek meg. Az AMD szűkszavúan nyilatkozott az RDNA 3 specifikációiról, de játékrajongó bloggerek meg nem erősített pletykákat terjesztettek az RDNA 2-höz képest 50-60%-os teljesítménynövekedésről.

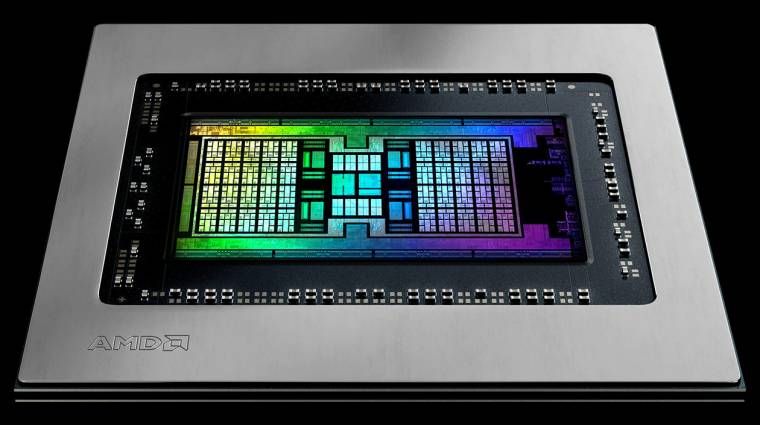

Időközben az AMD megkezdte a vállalati számítástechnika számára készült Instinct MI250 GPU-gyorsítók sorozatának szállítását, amelyek lényegesen gyorsabbak, mint a korábbi MI100-as sorozat. A memóriabusz 4096 bitről 8192 bitre, a memória sávszélessége több mint kétszeresére, 1,23TBps-ról 3,2TBps-ra nőtt, a teljesítmény pedig több mint négyszeresére, 11,5 TFLOPS FP64 teljesítményről 47,9TFLOPS-ra nőtt. Ez lassabb, mint az AMD Hopper 60TFLOPS-os teljesítménye, de még mindig versenyképes.

Daniel Newman, a Futurum Research vezető elemzője szerint az AMD piaci részesedésszerzési lehetősége az AI-piac növekedésével jön el. És elmondta, hogy szerinte az AMD sikere a CPU-piacon segítheti a GPU-eladásait. „Amit az AMD az elmúlt öt-hét évben valóban létrehozott, az egy elég erős lojalitás, ami esetleg tovább tud vinni” – mondta. „A kérdés az, hogy képesek-e jelentősen növelni az AI/HPC piaci részesedést.”

Szerinte a válasz az lehet, hogy „igen”, mert a vállalat rendkívül jól megtalálta a piaci lehetőségeket és úgy irányította az ellátási láncát, hogy elérje céljait. Lisa Su vezérigazgatóval az élen pedig „nagyon nehéznek tartom kizárni az AMD-t bármely olyan területen, ahol jelenleg úgy döntöttek, hogy versenybe szállnak” – mondta.

Jonathan Cassell, az Omdia fejlett számítástechnika, AI és IoT vezető elemzője szerint úgy érzi, hogy az AMD sikere az Epyc szerverprocesszorok esetében nyitást biztosít az Instinct processzor számára.

„Úgy gondolom, hogy idővel láthatjuk, hogy az AMD kihasználja az adatközpontok mikroprocesszorai terén elért sikereit, és ezt felhasználva a vállalatokat ráveszi, hogy nézzenek rá [az Instinctre]. Azt hiszem, látni fogjuk, hogy az AMD megpróbálja kihasználni az ügyfelekkel való kapcsolatait, hogy megpróbálja kiterjeszteni a jelenlétét” – mondta.

Az Instinct 2022 első negyedéve óta szállítható. Eddig a legjelentősebb felhasználási esete az Oak Ridge National Labs egyik szuperszámítógépe volt, amely nagyon kis helyre pakolta a nagy teljesítményt. A laboratóriumok azonban egy Frontier nevű, kizárólag AMD-s exascale szuperszámítógépet is építenek, amelyet még az idén üzembe helyeznek. Az Instinct-tel termékeket szállító OEM-partnerek közé tartozik az ASUS, az ATOS, a Dell Technologies, a Gigabyte, a Hewlett Packard Enterprise (HPE), a Lenovo, a Penguin Computing és a Supermicro.

Intel

Az Intel régóta küzd azzal, hogy asztali CPU-jaihoz az alapszintű integrált GPU-kon kívül komolyabb GPU-kat is készítsen. Az asztali számítógépekhez az új Intel Xe termékcsaládot fejleszti, míg a szerver megfelelője Intel Server GPU néven ismert.

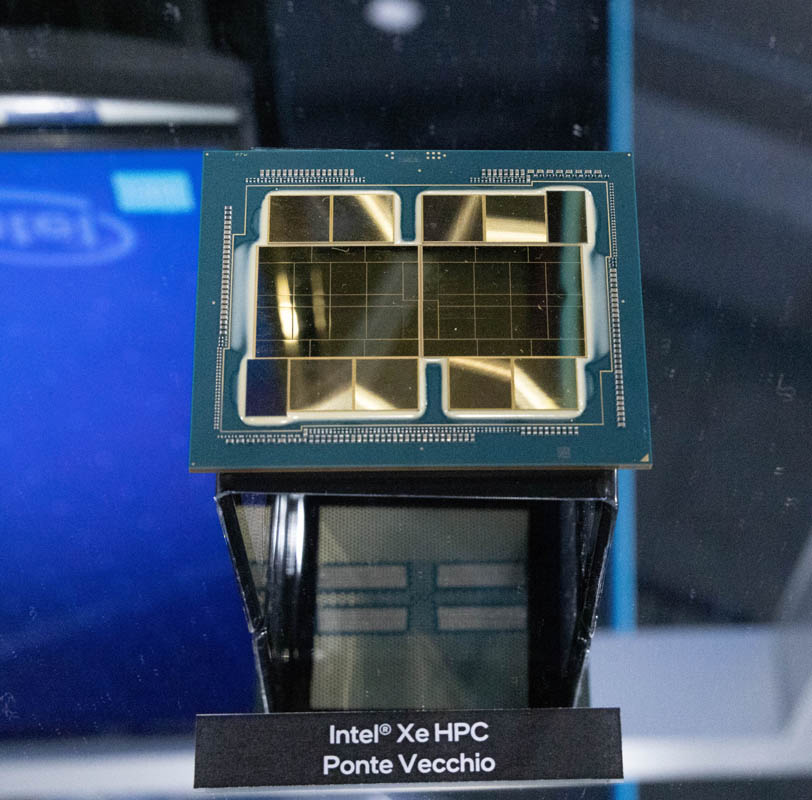

Most a vállalat azt állítja, hogy idén belép az adatközponti GPU-k mezőnyébe egy Ponte Vecchio kódnevű processzorral, amely állítólag 45TFLOPS-ot nyújt FP64-en – majdnem ugyanannyit, mint az AMD MI250 és 25%-kal kevesebbet, mint az Nvidia Hopper.

„Ez tényleg fel fogja borítani a környezetet” – mondta Peddie. „Abból, amit elmondtak nekünk – és amit pletykákból és más kiszivárgásokból hallottunk – nagyon jól skálázható”. A Ponte Vecchio még idén megjelenik.

Newman szintén pozitív dolgokat hallott a Ponte Vecchio-ról, de azt mondta, hogy az Intel számára az igazi lehetőséget a oneAPI szoftverstratégia jelenti.

A oneAPI egy olyan egységes szoftverfejlesztési platform, amelyen a vállalat dolgozik, és amelynek célja, hogy az alkalmazások fordításakor az Intel által gyártott szilícium legmegfelelőbb típusát – x86, GPU, FPGA, AI processzorok – válassza ki, ahelyett, hogy a fejlesztőnek egy szilíciumtípust kellene választania és arra kódolnia. Emellett számos API-könyvtárat is biztosít olyan funkciókhoz, mint a videófeldolgozás, a kommunikáció, az analitika és a neurális hálózatok.

Ez az absztrakció kiküszöböli annak szükségességét, hogy meg kelljen határozni, melyik processzort célozza meg a legjobban, valamint hogy különböző eszközökkel, könyvtárakkal és programozási nyelvekkel kelljen dolgozni. Így ahelyett, hogy egy adott processzorhoz egy adott nyelven kódolnának, a fejlesztők az üzleti logikára összpontosíthatnak, és Data Parallel C++ (DPC++) nyelven írhatnak, amely a C++ nyílt forráskódú változata, és amelyet kifejezetten az adatpárhuzamosságra és a heterogén programozásra terveztek.

Az egyik tényező, amely megkülönbözteti az Intelt az Nvidiától és az AMD-től, az, hogy hol gyártja a chipjeit. Míg a többiek a tajvani TSMC chipgyártót használják, az Intel sok saját chipjét az Egyesült Államokban gyártja, további gyárak Írországban, Malajziában és Izraelben vannak. És nagy tervei vannak arra, hogy még többet építsen az Egyesült Államokban. Cassell szerint ez bizonyos előnyökkel jár. „A saját gyártása feletti ellenőrzés bizonyos értelemben a sorsát is irányítja” – mondta. „Úgy látom, hogy ezek a dolgok előnyök a vállalat számára.”

Newman szerint az Nvidia, az AMD és az Intel közötti verseny végső soron egy szoftveres versenyben dőlhet el. „Ha megkérdeznénk [az Nvidia] vezető mérnökeit, azt mondanák, hogy mi nem chipgyártó cég vagyunk. Mi egy szoftvercég vagyunk. Tényleg úgy gondolom, hogy az Intel eddig nem igazán szoftvercégként gondolkodott a mesterséges intelligenciáról, de ha a [oneAPI-t] sikerül jól megvalósítaniuk, akkor komoly lehetőséget látok benne” – mondta.